新規作成日 2015-09-11

最終更新日

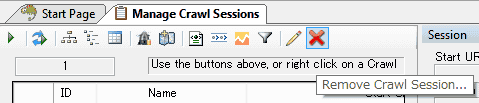

前回のクロールできなかったセッションを削除します。

順番に操作してきた場合、クロールできなかったセッションが残っているので削除します。

このページから操作している場合は、この操作は必要ありません。

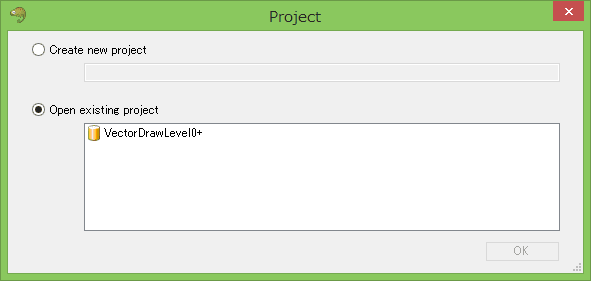

前回サイトを登録したので、起動すると一覧にサイトが表示されます。クロールするサイトを選択し、OKをクリックします。

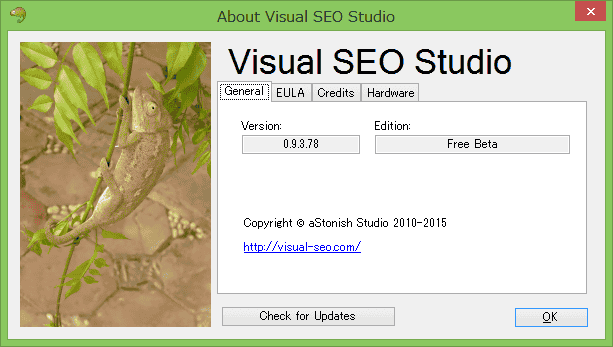

操作を説明する前に、バージョンを確認します。古いバージョンの場合、機能が存在しない場合があります。

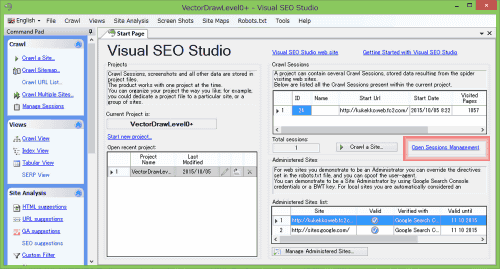

順番に、操作してきた場合は、前回のクロールできなかったセッションが残っています。まず、これを削除します。

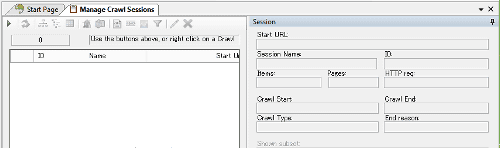

StartPageタグから、Open Session Managementを選択します。

赤い×アイコンをクリックし、セッションを削除します。

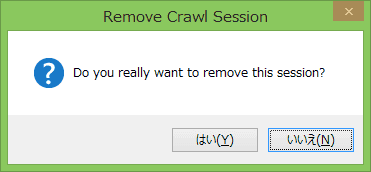

確認ダイアログが表示されます。

セッションが削除されました。右側の×アイコンをクリックするとタブを閉じることができます。

クロールする

あらためて、robots.txtが存在しないサイトをクロールします。

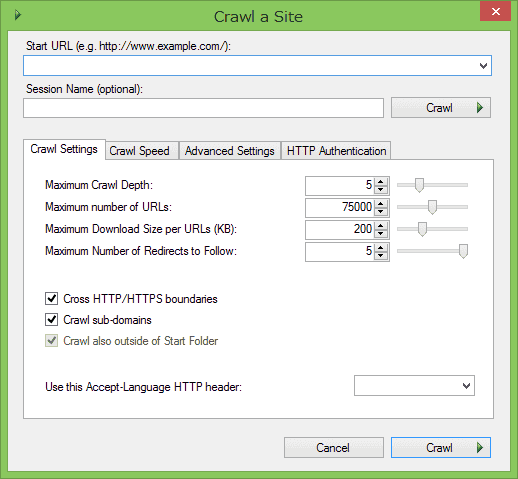

メインメニュー、あるいは、左の枠にある「Crawl a site...」をクリックします

「Start

URL」に、クロールするサイトのドメインを入力します。ドロップダウンリストで選択できます。後は、デフォルトで、「Crawl」をクリックし、動作を確認します。

「Crawl Setting」のタブです。

「Crawl Setting」のタブです。

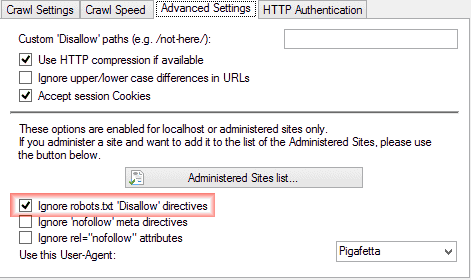

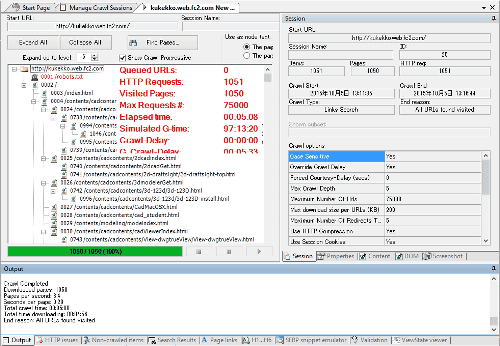

「Advance Settings」のタブです。

「Ignore robots.txt 'Disallow' directives」のチェックボックスにチェックを入れ、「Crawl」ボタンをクリックします。

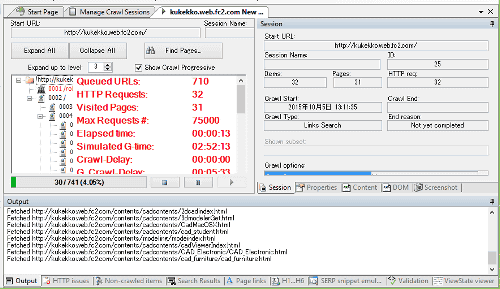

クロールが始まります。

今回は、きちんとクロールが進行します。

クロールが完了しました。

次は、サイトマップを作成します。